GoTo AI Trust Center

Última modificación: 3 de marzo de 2025

Introducción

GoTo proporciona a sus clientes herramientas que ayudan a aumentar la productividad y la eficiencia integrando servicios de inteligencia artificial (IA) en los productos de comunicación empresarial, colaboración, asistencia remota y gestión de TI ("Servicios de GoTo").

Usamos modelos de lenguaje de gran tamaño (LLM) y modelos de IA fundacionales para ofrecer asistencia a un número creciente de casos de uso en todos los Servicios de GoTo, como asistentes de IA interactivos, sugerencias de solución de problemas de TI, generación y análisis de scripts de gestión de TI, resúmenes de reuniones y llamadas e información empresarial operativa.

Aunque la IA ofrece ventajas significativas, también es una tecnología que evoluciona a gran velocidad y presenta sus riesgos. En esta página explicamos las prácticas de desarrollo seguro de GoTo, diseñadas para gestionar estos riesgos y ayudar a los clientes a beneficiarse de las funciones y la funcionalidad de la IA.

La privacidad y la seguridad son prioritarias para GoTo al diseñar cualquier función de IA. Si desea más información sobre los programas de privacidad y seguridad de GoTo, visite Trust Center.

Uso responsable de la IA en GoTo

GoTo se compromete a usar de forma responsable la inteligencia artificial para proporcionar funciones de producto que aumenten la eficiencia y proteger contra resultados que sean poco éticos o perjudiciales por cualquier otro motivo. Por eso, nuestras funciones de producto con IA están diseñadas teniendo en cuenta los principios de la IA responsable:

- Equidad. Medidas de protección contra resultados sesgados o discriminatorios, lo que incluye reducir al mínimo el uso de entradas de datos que puedan conducir a un comportamiento discriminatorio del modelo.

- Transparencia. Los usuarios y los clientes saben que están interactuando con IA y usando funciones de IA. GoTo explica cómo y dónde se incorpora IA a los productos, y cómo funciona.

- Responsabilidad. Se han implementado mecanismos de supervisión y auditoría para identificar resultados inesperados o perjudiciales. Las funciones están diseñadas para permitir la supervisión y el control humanos de forma acorde con los riesgos y la naturaleza de la función de IA.

- Privacidad y seguridad. GoTo implementa diseños de sistema robustos con pruebas y supervisión periódicas para proteger los datos. La privacidad por diseño está incorporada a las funciones de IA, que tratan la cantidad mínima de datos necesaria para su propósito.

- Uso ético. La IA se usa con propósitos positivos y no perjudiciales. Existen controles para proteger contra alucinaciones de la IA, desinformación, inexactitudes, violaciones de los derechos humanos y otros resultados perjudiciales.

Principio rector: nuestro modelo de confianza de IA

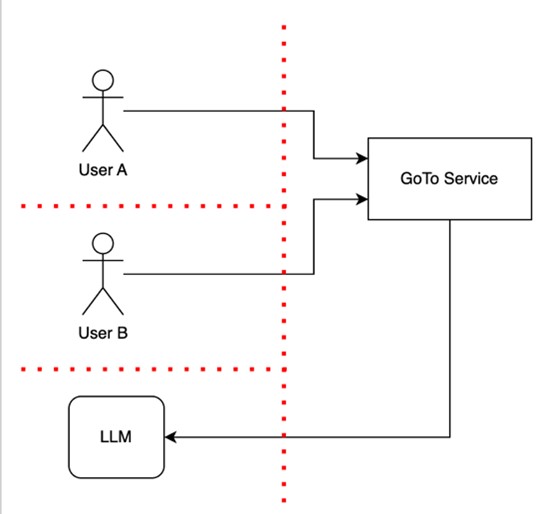

El enfoque de GoTo para el diseño de funciones de IA incluye implementar barreras de confianza para separar los datos de los usuarios entre sí y de la infraestructura del producto. En este modelo de confianza, una infraestructura de confianza no puede incluir ni personas ni modelos de IA en el mismo enclave de confianza, como se muestra en el siguiente diagrama.

El diagrama muestra a dos usuarios, Usuario A y Usuario B, que usan un Servicio de GoTo que incluye una función de LLM, indicada por la flecha hacia un LLM. La línea roja representa barreras de confianza aseguradas para proteger la información confidencial y la funcionalidad, y para separar a los usuarios entre sí y de la infraestructura del producto, incluido el LLM. Estas barreras de confianza permiten realizar comprobaciones de confianza (por ejemplo, autenticación, autorización y comprobaciones de coherencia) cuando los flujos de controles o datos las atraviesan.

Como muestra este diagrama, Usuario B no tiene acceso a datos ni dispositivos pertenecientes a Usuario A.

Este modelo de confianza ayuda a proteger los datos del cliente contra el acceso o el uso no autorizados y los Servicios de GoTo contra ataques o vulnerabilidades.

Mecanismos de salvaguardia

Al diseñar aplicaciones o funciones de LLM, GoTo se informa sobre los riesgos específicos de los LLM y los demás riesgos relacionados con la IA, como la inyección de prompts, el envenenamiento de datos de entrenamiento y las vulnerabilidades de la cadena de suministro, e implementa salvaguardias para mitigarlos. Teniendo en cuenta el modelo de confianza de GoTo y los riesgos generales de la IA, utilizamos varios mecanismos detallados a continuación, como el control humano y la tenencia múltiple, diseñados para ayudar a los usuarios a beneficiarse de las aplicaciones y las funciones de IA de un modo que aumente la seguridad de los datos.

Aunque los modelos de IA proporcionan valiosos mecanismos para automatizar tareas, generar respuestas a consultas y producir diversos artefactos, es importante que los usuarios recuerden que estos modelos difieren de los servicios de software tradicionales en que pueden producir respuestas incorrectas o resultados no deseados. Cuando use aplicaciones de IA, la confianza depositada en los resultados de los modelos de IA (incluidos los LLM) debe ser similar a su nivel de confianza en los resultados creados por otros usuarios. En resumen, confíe, pero verifique: siempre debe verificar la integridad y la exactitud de los resultados de IA generados en respuesta a sus prompts.

Teniendo esto en cuenta, se han implementado los siguientes mecanismos de salvaguardia en los lugares adecuados cuando se incorpora IA a los Servicios de GoTo:

- Control humano. Las funciones de IA están diseñadas para dar al usuario la última palabra sobre si se usa el resultado generado por un modelo de IA (como un LLM) y cómo se usa. Los usuarios de los productos mantienen el control, y las acciones delicadas requieren aprobación humana.

- Tenencia múltiple con LLM. GoTo garantiza que cada usuario tenga sesiones (conversaciones) separadas con el servicio de LLM, a las que no pueden acceder otros usuarios. Esto significa que los demás usuarios no pueden acceder a información confidencial compartida accidentalmente en un prompt.

- Ningún tercero usa datos del cliente para entrenar su servicio de LLM. Cuando se proporcionan funciones de IA mediante proveedores externos, estos proveedores tienen prohibido usar datos de los clientes de GoTo para el entrenamiento.

- Validación de entradas y salidas. Los Servicios de GoTo validan el formato de las entradas usando técnicas de validación habituales, como expresiones regulares y analizadores sintácticos. Nuestros Servicios rechazan determinados tipos de entradas y salidas inesperadas basándose en los resultados de la validación, para reducir los riesgos de seguridad, impedir la pérdida o el daño de datos y reducir al mínimo los errores. Por ejemplo, validamos entradas y salidas inesperadas que parezcan inyecciones de texto, prompts irrelevantes, datos dañados o casos de error no forzados.

Transparencia: uso de funciones de IA

Nos esforzamos por identificar claramente las funciones con IA en los Servicios de GoTo. Por ejemplo, identificamos textualmente o con un icono de brillo las funciones que aprovechan la IA, como se muestra a continuación. Nuestros clientes pueden decidir si desean usar la función o el resultado proporcionado. En algunos casos, los usuarios o los clientes pueden desactivar las funciones de IA que no deseen usar. Consulte las páginas de asistencia específicas de cada producto si desea más información.

Ejemplos de identificación de funciones de IA:

Transparencia: uso de datos

En casos limitados, y solo cuando los clientes tengan capacidad de decisión sobre este uso, GoTo puede usar datos de cliente para entrenar modelos de IA de GoTo y ayudar a mejorar la calidad general de los resultados de un producto. Con los clientes que permiten este uso de datos, GoTo toma medidas para tratar solo la información necesaria, limitando las solicitudes de los LLM a detalles contextuales esenciales, como se explica más a fondo a continuación, en la sección "Minimización de los datos". Como ejemplo de este enfoque, consulte Preguntas frecuentes sobre el uso de contenido de usuario que hace LogMeIn Resolve.

Proporcionamos más información sobre el uso de funciones de IA en los productos de GoTo en Términos de IA de GoTo, que se aplican al uso de estas funciones que haga un usuario.

Minimización de los datos

GoTo se esfuerza por limitar las solicitudes de los LLM a detalles contextuales esenciales. Por ejemplo, si un cliente desea incluir detalles contextuales en una entrada para que un LLM aumente la exactitud, los Servicios de GoTo se esfuerzan por aprovechar solo información relevante en contexto mediante una técnica denominada generación aumentada por recuperación (RAG). Por ejemplo, al diagnosticar un dispositivo en LogMeIn Resolve o Rescue, incluimos datos del dispositivo como la CPU y la memoria, pero evitamos los datos personales sobre los usuarios del dispositivo.

Mínimo privilegio y riesgo basado en funciones

Al diseñar los Servicios de GoTo, incluidas las funciones de IA, seguimos un enfoque basado en riesgos y el principio de mínimo privilegio, lo que significa que un servicio de IA solo tiene acceso a los datos o los recursos específicos necesarios (es decir, limitamos técnicamente el acceso a los datos, por ejemplo, usando roles técnicos con privilegios de acceso restringidos).

Antes de implementar una función de IA, estudiamos los riesgos basados en funciones. Para limitar el acceso adecuadamente, restringimos los privilegios y los datos a los que puede acceder un servicio de IA a los necesarios para que pueda usarse la función.