GoTo AI Trust Center

Dernière modification le 3 mars 2025

Introduction

GoTo met à la disposition de ses clients des outils qui les aident à accroître leur productivité et leurs performances en intégrant des services d’intelligence artificielle (IA) dans ses produits de communication d’entreprise, de collaboration, d’assistance à distance et de gestion informatique (les « services GoTo »).

Nous utilisons des grands modèles de langage (LLM) et des modèles d’IA fondamentaux pour prendre en charge un nombre croissant de cas d’utilisation dans nos services GoTo, tels que les assistants interactifs basés sur l’IA, les suggestions de dépannage informatique, la génération et l’analyse de scripts de gestion informatique, le résumé de réunions et d’appels, et la fourniture d’informations opérationnelles sur les entreprises.

Si l’IA offre des avantages considérables, il s’agit également d’une technologie qui évolue rapidement et s’accompagne de risques potentiels. Nous expliquons sur cette page l’approche de GoTo relative aux pratiques de développement sécurisées conçues pour gérer ces risques et aider nos clients à bénéficier de caractéristiques et fonctionnalités basées sur l’IA.

La confidentialité et la sécurité sont au cœur des préoccupations de GoTo lorsqu’il conçoit une quelconque fonctionnalité d’IA. Pour plus d’informations sur les programmes de confidentialité et de sécurité de GoTo, veuillez visiter notre Trust Center.

Utilisation responsable de l’IA chez GoTo

GoTo s’engage à utiliser l’intelligence artificielle de manière responsable pour fournir des fonctionnalités de produit qui favorisent l’efficacité tout en protégeant contre les sorties contraires à l’éthique ou autrement préjudiciables. Ainsi, les fonctionnalités de nos produits basés sur l’IA sont conçues en tenant compte des principes d’une IA responsable :

- Équité. Des protections contre les sorties biaisées ou discriminatoires, en minimisant l’utilisation de données d’entrée qui peuvent conduire à un comportement discriminatoire du modèle.

- Transparence. Les clients et les utilisateurs finaux savent qu’ils interagissent avec l’IA et qu’ils utilisent des fonctionnalités basées sur l’IA. GoTo explique comment et où l’IA est incorporée dans les produits et comment elle fonctionne.

- Responsabilité. Des mécanismes de contrôle et d’audit sont mis en œuvre pour identifier les sorties inattendues ou préjudiciables. Les fonctionnalités sont conçues pour permettre une surveillance et un contrôle humains proportionnels aux risques et à la nature de la fonctionnalité basée sur l’IA.

- Confidentialité et sécurité. GoTo conçoit des systèmes robustes, soumis à des tests et des contrôles réguliers pour protéger les données. Le respect de la vie privée dès la conception est intégré dans la conception des fonctions d’IA, qui sont conçues pour ne traiter que la quantité minimale de données nécessaires à leur finalité.

- Utilisation éthique. L’IA est utilisée à des fins positives et non nuisibles. Des contrôles sont en place pour prévenir les hallucinations, la désinformation, les inexactitudes, les violations des droits de l’homme et d’autres résultats potentiellement nuisibles de l’IA.

Principe directeur : Notre modèle de confiance lié à l’IA

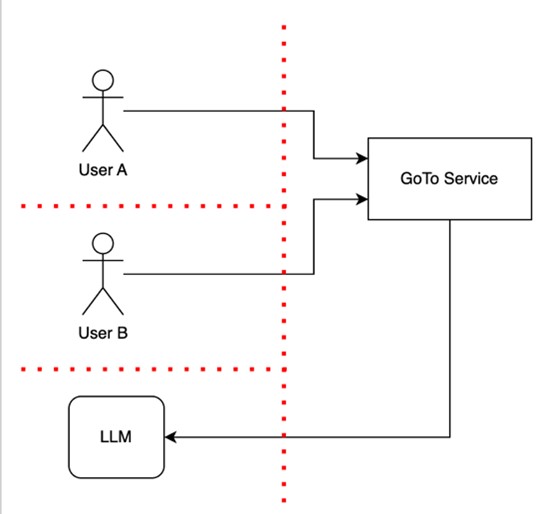

L’approche de GoTo de la conception des fonctionnalités d’IA consiste à mettre en place des barrières de confiance pour séparer les données des utilisateurs les unes des autres ainsi que de l’infrastructure du produit. Ce modèle de confiance considère qu’une infrastructure fiable ne peut pas inclure des humains ou des modèles d’IA dans la même enclave de confiance, comme le montre le diagramme ci-dessous.

Le diagramme montre deux utilisateurs, l’utilisateur A et l’utilisateur B, utilisant un service GoTo qui comprend une fonctionnalité basée sur le LLM, indiquée par la flèche vers un LLM. La ligne rouge représente les barrières de confiance qui sont sécurisées pour protéger les informations et les fonctionnalités sensibles, et pour séparer les utilisateurs les uns des autres et de l’infrastructure du produit, y compris le LLM. Ces barrières de confiance permettent d’effectuer des contrôles de confiance (par exemple, des contrôles d’authentification, d’autorisation et d’intégrité) lorsque des flux de contrôle ou de données les franchissent.

Comme le montre ce diagramme, l’utilisateur B n’a pas accès aux données ou aux appareils de l’utilisateur A.

Ce modèle de confiance aide à protéger les données du client contre tout accès ou utilisation non autorisés, et aide à protéger les Services de GoTo des vulnérabilités ou des attaques.

Mécanismes de protection

Lors de la conception d’applications LLM ou de fonctions basées sur les LLM, GoTo demeure informé des risques spécifiques au LLM et d’autres risques liés à l’IA, tels que l’injection d’invite, l’empoisonnement des données d’entraînement et les vulnérabilités de la chaîne d’approvisionnement, et met en œuvre des mesures de protection pour y remédier. Tenant compte du modèle de confiance de GoTo et des risques généraux liés à l’IA, nous utilisons plusieurs mécanismes détaillés ci-dessous, tels que le contrôle humain et la mutualisation, qui sont conçus pour aider nos utilisateurs à bénéficier des applications et des fonctionnalités de l’IA d’une manière qui promeut la sécurité des données.

Bien que les modèles d’IA fournissent de précieux mécanismes pour automatiser des tâches, générer des réponses à des requêtes et produire divers artefacts, les utilisateurs ne doivent pas perdre de vue que ces modèles diffèrent des services logiciels traditionnels en ce sens qu’ils peuvent produire des réponses incorrectes ou des sorties inattendues. Lorsque vous utilisez des applications basées sur l’IA, la confiance que vous accordez aux résultats des modèles d’IA (y compris les LLM) doit être similaire au niveau de confiance que vous accordez aux résultats créés par d’autres utilisateurs. En bref, faites confiance mais vérifiez : vous devez toujours vérifier l’exhaustivité et l’exactitude des résultats de l’IA en réponse à vos invites.

Dans cette optique, les mécanismes de protection suivants sont mis en œuvre, le cas échéant, lorsque l’IA est incorporée dans les services GoTo :

- Contrôle humain. Les fonctionnalités basées sur l’IA sont conçues pour permettre à l’utilisateur de décider en dernier ressort si et comment il souhaite utiliser le résultat généré par un modèle d’IA (tel qu’un LLM). Les utilisateurs des produits gardent le contrôle, et les actions sensibles requièrent l’approbation d’un être humain.

- Mutualisation avec les LLM. GoTo garantit que les utilisateurs individuels mènent des sessions séparées (conversations) avec le service de LLM, qui ne sont pas accessibles aux autres utilisateurs. Cela signifie que les autres utilisateurs ne peuvent pas accéder aux informations sensibles partagées par inadvertance dans une invite.

- Les données des clients ne sont pas utilisées par des tiers pour la formation de leur service de LLM. Lorsqu’ils fournissent des fonctionnalités d’IA par l’intermédiaire d’un fournisseur tiers, ces derniers n’ont pas le droit d’utiliser les données des clients de GoTo à des fins de formation.

- Validation des données d’entrée et de sortie. Les services GoTo valident le format des entrées à l’aide de techniques de validation courantes, notamment les expressions régulières et les analyseurs syntaxiques. Nos services rejettent certains types d’entrées et de sorties inattendues en fonction des résultats de la validation afin de réduire les risques de sécurité, d’éviter la perte ou la corruption de données et de minimiser les erreurs. À titre d’exemple, nous validons les entrées et sorties inattendues qui semblent être des injections de texte, des invites non pertinentes, des données corrompues ou des cas d’erreurs non provoquées.

Transparence : utilisation des fonctionnalités de l’IA

Nous nous efforçons d’identifier clairement les fonctionnalités des services GoTo qui sont basées sur l’IA. Par exemple, nous identifions les fonctionnalités qui exploitent l’IA, de manière textuelle ou à l’aide d’une icône en forme d’étincelle, comme illustré ci-dessous. Nos clients peuvent choisir s’ils souhaitent utiliser la fonctionnalité ou le résultat fourni. Dans certains cas, les clients ou les utilisateurs peuvent choisir de désactiver les fonctionnalités basées sur l’IA qu’ils ne souhaitent pas utiliser. Pour plus d’informations, veuillez consulter les pages d’assistance spécifiques à chaque produit.

Exemples d’identification des fonctionnalités d’IA :

Transparence : utilisation des données

Dans certains cas exceptionnels, et uniquement lorsque les clients ont le choix de refuser cette utilisation, GoTo pourra utiliser les données des clients pour former ses modèles d’IA et aider à améliorer la qualité de sortie globale d’un produit. Pour les clients qui choisissent d’autoriser cette utilisation des données, GoTo veille à ne traiter que les informations nécessaires, en limitant les demandes de LLM aux détails contextuels essentiels, comme expliqué ci-dessous dans la section « Minimisation des données ». Vous trouverez un exemple de cette approche dans la FAQ sur l’utilisation du contenu utilisateur de LogMeIn Resolve.

Nous fournissons de plus amples informations sur l’utilisation des fonctionnalités basées sur l’IA dans les produits GoTo sur le site Conditions d’utilisation de l’IA de GoTo, qui s’applique à l’utilisation de ces fonctions par un client.

Minimisation des données

GoTo cherche à limiter les requêtes des LLM aux détails contextuels essentiels. Par exemple, si un client souhaite inclure des détails contextuels dans une entrée afin d’améliorer la précision d’un LLM, les services GoTo cherchent à exploiter uniquement les informations qui sont pertinentes dans le contexte en utilisant une technique appelée Génération Augmentée de Récupération (Retrieval-augmented generation ou RAG). Par exemple, lors du diagnostic d’un appareil dans LogMeIn Resolve ou Rescue, nous incluons les données de l’appareil telles que le processeur et la mémoire, mais nous évitons toute donnée personnelle sur les utilisateurs de l’appareil.

Moindre privilège et risque basé sur la fonctionnalité

Lors de la conception des services GoTo, y compris des fonctionnalités basées sur l’IA, nous suivons une approche fondée sur les risques et le principe du moindre privilège, ce qui signifie qu’un service d’IA n’a accès qu’aux données ou ressources spécifiques nécessaires (c’est-à-dire que nous limitons techniquement l’accès aux données, par exemple en utilisant des rôles techniques avec des privilèges d’accès restreints).

Avant de décider de déployer une fonctionnalité basée sur l’IA, nous prenons en compte les risques liés à cette fonctionnalité. Pour restreindre l’accès de manière appropriée, nous limitons les privilèges et les données auxquels un service d’IA peut accéder à ce qui est nécessaire au fonctionnement de la fonctionnalité.