Centro de Confiança de IA da GoTo

Última modificação: 3 de março de 2025

Introdução

A GoTo dá autonomia aos clientes com ferramentas para ajudá-los a aumentar a produtividade e a eficiência, integrando serviços de inteligência artificial (IA) em nossos produtos de comunicação empresarial, colaboração, suporte remoto e gerenciamento de TI ("Serviços GoTo").

Usamos grandes modelos de linguagem (LLMs, na sigla em inglês) e modelos de base para IA para dar suporte a um número crescente de casos de uso em nossos Serviços GoTo, como assistentes interativos baseados em IA, sugestões de solução de problemas de TI, geração e análise de scripts de gerenciamento de TI, resumo de reuniões e chamadas e fornecimento de insights empresariais práticos.

Embora a IA ofereça benefícios significativos, ela também é uma tecnologia em rápida evolução com riscos potenciais. Nesta página, explicamos a abordagem da GoTo em relação às práticas de desenvolvimento seguro criadas para gerenciar esses riscos e ajudar nossos clientes a se beneficiarem da funcionalidade e dos recursos baseados em IA.

A privacidade e a segurança são as principais preocupações quando a GoTo projeta qualquer recurso de IA. Para mais informações sobre os programas de Privacidade e Segurança da GoTo, acesse nosso Centro de Confiança.

Uso responsável de IA na GoTo

A GoTo está comprometida com o uso responsável de inteligência artificial para fornecer recursos de produtos que promovem a eficiência, além de proteção contra resultados antiéticos ou prejudiciais. Dessa forma, nossos recursos de produtos habilitados para IA são projetados com os princípios de IA responsável em mente:

- Equidade. Proteções contra resultados tendenciosos ou discriminatórios, incluindo a minimização do uso de entradas de dados que podem levar a um comportamento discriminatório do modelo.

- Transparência. Os clientes e usuários sabem que estão interagindo com uma IA e usando recursos habilitados para IA. A GoTo explica como e onde a IA é incorporada nos produtos e como ela funciona.

- Responsabilidade. Mecanismos de supervisão e auditoria são implementados para identificar resultados inesperados ou prejudiciais. Os recursos são projetados para permitir a supervisão e o controle humanos de forma proporcional aos riscos e à natureza do recurso habilitado para IA.

- Privacidade e segurança. A GoTo implementa projetos de sistemas robustos com testes e monitoramento regulares para proteger os dados. A privacidade desde a concepção é incorporada à criação dos recursos habilitados para IA, que são projetados para processar apenas a quantidade mínima de dados necessária para cumprir seu propósito.

- Uso ético. A IA é usada para fins positivos e não prejudiciais. Existem controles em vigor para proteger contra alucinações de IA, desinformação, imprecisões, violações de direitos humanos e outros resultados potencialmente prejudiciais.

Princípio orientador: nosso modelo de confiança de IA

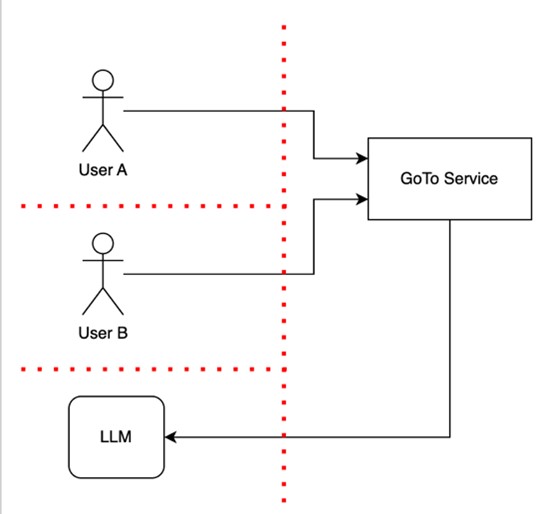

A abordagem da GoTo para a criação de recursos de IA envolve a implementação de barreiras de confiança para separar os dados dos usuários uns dos outros, bem como da infraestrutura do produto. Esse modelo de confiança considera que uma infraestrutura confiável não pode incluir humanos ou modelos de IA no mesmo enclave de confiança e é demonstrado no diagrama abaixo.

O diagrama mostra dois usuários, o Usuário A e o Usuário B, usando um Serviço GoTo que inclui um recurso baseado em LLM, indicado pela seta apontando para um LLM. A linha vermelha representa as barreiras de confiança que são protegidas para resguardar funcionalidades e informações confidenciais e para separar os usuários uns dos outros e da infraestrutura do produto, incluindo o LLM. Essas barreiras de confiança permitem verificações de confiança (p.ex., autenticação, autorização e verificações de sanidade) sempre que os fluxos de controle ou de dados as atravessam.

Como mostra esse diagrama, o Usuário B não tem acesso aos dados ou dispositivos que pertencem ao Usuário A.

Esse modelo de confiança ajuda a proteger os dados do Cliente contra acesso ou uso não autorizado e ajuda a proteger os Serviços GoTo contra ataques ou vulnerabilidades.

Mecanismos de salvaguarda

Ao projetar aplicativos de LLM ou recursos baseados em LLM, a GoTo se mantém informada sobre os riscos específicos do LLM e outros riscos relacionados à IA, como injeção de prompt, envenenamento de dados de treinamento e vulnerabilidades da cadeia de suprimentos, e implementa salvaguardas para lidar com eles. Com o modelo de confiança da GoTo e os riscos gerais relacionados à IA em mente, utilizamos vários mecanismos que são detalhados abaixo, como humano no controle e arquitetura multilocatária, e que são projetados para ajudar nossos usuários a se beneficiarem dos aplicativos e recursos de IA de uma forma que promova a segurança dos dados.

Embora os modelos de IA forneçam mecanismos valiosos para automatizar tarefas, gerar respostas para dúvidas e produzir vários artefatos, é importante que os usuários se lembrem de que esses modelos diferem dos serviços de software tradicionais, pois podem produzir respostas incorretas ou resultados não intencionais. Ao usar aplicativos baseados em IA, a confiança que você deposita nos resultados dos modelos de IA (incluindo LLMs) deve ser semelhante ao seu nível de confiança nos resultados criados por outros usuários. Em resumo, confie, mas verifique: você deve sempre verificar a integridade e a precisão dos resultados de IA em resposta aos seus prompts de usuário.

Com isso em mente, os seguintes mecanismos de salvaguarda são implementados, quando apropriado, quando a IA é incorporada nos Serviços GoTo:

- Humano no controle. Os recursos habilitados para IA são projetados para dar ao usuário a última palavra sobre se e como o resultado gerado por um modelo de IA (como um LLM) é usado. Os usuários que usam os produtos permanecem no controle, e as ações sensíveis exigem aprovação humana.

- Arquitetura multilocatária com LLM. A GoTo garante que cada usuário tenha sessões (conversas) separadas com o serviço de LLM, que não podem ser acessadas por outros usuários. Isso significa que outros usuários não podem acessar informações confidenciais compartilhadas inadvertidamente em um prompt.

- Os dados do cliente não são usados por terceiros para treinamento de seus serviços de LLM. Ao fornecer recursos habilitados para IA por meio de um provedor terceirizado, os provedores terceirizados ficam proibidos de usar os dados dos clientes GoTo para fins de treinamento.

- Validação de entrada e saída. Os serviços da GoTo validam o formato das entradas usando técnicas comuns de validação, incluindo expressões regulares e analisadores. Nossos Serviços rejeitam determinados tipos de entradas e saídas inesperadas com base nos resultados da validação para reduzir riscos de segurança, evitar perda ou corrupção de dados e minimizar erros. Por exemplo, validamos entradas e saídas inesperadas que parecem ser injeções de texto, prompts irrelevantes, dados corrompidos ou casos de erros não forçados.

Transparência: uso de recursos de IA

Nós trabalhamos com afinco para identificar claramente os recursos que são habilitados para IA nos Serviços GoTo. Por exemplo, identificamos recursos que fazem uso de IA textualmente ou com um ícone de brilho, conforme mostrado abaixo. Nossos clientes podem escolher se querem usar o recurso ou a saída resultante fornecida. Em alguns casos, os clientes ou usuários podem optar por desativar os recursos habilitados para IA que não desejam usar. Para mais informações, consulte as páginas de suporte específicas do produto.

Exemplos de identificação de recursos de IA:

Transparência: uso de dados

Em casos limitados, e somente quando os clientes puderem optar por este uso, a GoTo poderá usar os dados do cliente para treinar os modelos de IA da GoTo e ajudar a melhorar a qualidade geral dos resultados gerados por um produto. Para os clientes que optam por permitir esse uso de dados, a GoTo toma medidas para processar apenas as informações necessárias, limitando as solicitações de LLM a detalhes contextuais essenciais, conforme explicado mais detalhadamente abaixo, na seção "Minimização de dados". Como exemplo dessa abordagem, consulte as Perguntas frequentes — Uso de conteúdo do usuário LogMeIn Resolve.

Fornecemos mais informações sobre o uso de recursos habilitados para IA nos produtos GoTo nos Termos GoTo para IA, que se aplicam ao uso desses recursos pelo cliente.

Minimização de dados

A GoTo busca limitar as solicitações de LLM a detalhes contextuais essenciais. Por exemplo, se um cliente quiser incluir detalhes contextuais em uma entrada para um LLM para melhorar a precisão, os Serviços GoTo procuram utilizar apenas as informações que são relevantes no contexto usando uma técnica chamada geração aumentada de recuperação (RAG, na sigla em inglês). Por exemplo, ao diagnosticar um dispositivo no LogMeIn Resolve ou Rescue, incluímos dados do dispositivo, como CPU e memória, mas evitamos quaisquer dados pessoais sobre os usuários do dispositivo.

Menos privilégio e risco baseado em recursos

Ao criar os Serviços GoTo, incluindo os recursos habilitados para IA, seguimos uma abordagem baseada em riscos e o princípio do menor privilégio, o que significa que um serviço de IA só tem acesso aos dados ou recursos específicos necessários (ou seja, restringimos tecnicamente o acesso aos dados, por exemplo, usando funções técnicas com privilégios de acesso restritos).

Antes de decidirmos implementar um recurso habilitado para IA, consideramos os riscos baseados em recursos. Para restringir adequadamente o acesso, limitamos os privilégios e os dados que um serviço de IA pode acessar apenas ao que é necessário para que o recurso funcione.